utworzone przez Marcin Żmigrodzki

Przy okazji niedawnego szkolenia w ręce wpadła mi metodyka PRISM przygotowana przez stowarzyszenie Green Project Management. Postanowiłem się podzielić moimi spostrzeżeniami na temat tej metodyki i w ogóle podejścia Green Project Management.

Przy okazji niedawnego szkolenia w ręce wpadła mi metodyka PRISM przygotowana przez stowarzyszenie Green Project Management. Postanowiłem się podzielić moimi spostrzeżeniami na temat tej metodyki i w ogóle podejścia Green Project Management.

GPM jest stowarzyszeniem przypominającym nieco PMI 40 lat temu. Chyba stowarzyszeniem, bo trudno mi było znaleźć na ich witrynie konkretne dane rejestrowe. Ale odnoszę wrażenie, że grupa woluntariuszy zorganizowała się wokół wspólnej idei uczynienia inwestycji projektowych bardziej zielonymi.

GPM oferuje 3 poziomy certyfikatów, które w formule ich zdobywania bardzo przypominają PRINCE2 Foundation i Practitioner. Krótkie test albo studium przypadku i rozmowa. Szybki test ilości ogłoszeń o pracę wymagających któregoś z tych certyfikatów pokazuje, że jeszcze długa droga przed nimi. Dla porównania PMP w momencie pisania tego tekstu występował w Polsce w ponad 5000 ogłoszeń, GPM-b + GPM-s + GPM-m w żadnym, dosłownie zero ogłoszeń. Rozszerzyłem wyszukiwanie na USA i wyniki były identyczne 347 000 do zera na korzyść PMP. Nie oceniam w żadnym wypadku merytoryki tych certyfikatów tylko popularność wśród pracodawców, ale uważam, że ten wskaźnik jest niestety bardziej pragmatyczny.

Wiedza na certyfikacji bazuje na kolejnym komponencie, czyli metodyce PRISM. De facto nie zdefiniowałbym PRISM jako metodyki, ale raczej nakładki na metodykę, która podkreśla istotność pewnych obszarów. Czyli PRISM nie powie, jak prowadzić projekt, tylko, jakie postawy i zachowania są pożądane w projekcie.

A te postawy należą do trzech grup: środowisko naturalne, lokalna społeczność i prawa człowieka. PRISM promuje prowadzenie projektów zgodne z prawem, promujące lokalną ekonomię, dbanie o interesy lokalnej ludności, poszanowanie praw człowieka takich, jak work-life balance, uczciwa płaca, brak dyskryminacji itp.

Problemem dla mnie jest fakt, że te dobre praktyki są przedstawione na poziomie bardzo ogólnym. PRISM nie mówi, co operacyjnie robić, tylko, co warto mieć na uwadze. Oznacza to, że z dużą łatwością można wdrożyć PRISM bardzo fasadowo. Wystarczy zademonstrować kiika przykładów właściwych starań.

PRISM jest metodyką kaskadową. Promuje się z góry zdefiniowany cykl życia projektu składający się z inicjacji, 4 etapów projektowych i etapu obserwowania korzyści po projekcie. Fajne jest uwzględnienie zarządzania korzyściami, którego brakuje w PMBOK a jest obecne w Standard for Program Management PMI.

Godne uznania jest też ujęcie w cyklu życia etapu eksploracji, w trakcie którego zespół zdobywa wiedzę o możliwych do realizacji koncepcjach. Jak widać eksploracja przebija się powoli do świadomości w różnych inicjatywach.

Za wyjątkiem jednak kilku praktyk brakuje w PRISM konkretów. Brakuje operacyjności, czyli wiedzy jak wdrożyć PRISM w konkretnej sytuacji. Jest to szczególnie istotne, bo GPM proponuje audyt organizacji w zakresie wdrożenia ich metodyki.

Podsumowując, GPM jest mało znaną inicjatywą, która od kilkunastu lat próbuje się przebić na rynek. Przebija się za pomocą certyfikatów, metodyki PRISM oraz audytów organizacji PSM3. Jednak odnoszę wrażenie, że o ile jakaś regulacja unijna nie wymusi malowania projektów na zielono, to długa droga przed GPM, aby osiągnąć status zbliżony do PRINCE, IPMA, czy PMI.

Tytułowe zdjęcie: Bart Ros https://www.pexels.com/pl-pl/zdjecie/drewno-droga-swit-krajobraz-10915473/

Ps.

Emilia wysłała mi informacje rejestracyjne GPM, które udało się odnaleźć po rejestracji znaku towarowego. GPM okazuje się być spółką z ograniczoną odpowiedzialnością (LLC) zlokalizowaną w Fort Wayne.

utworzone przez Marcin Żmigrodzki

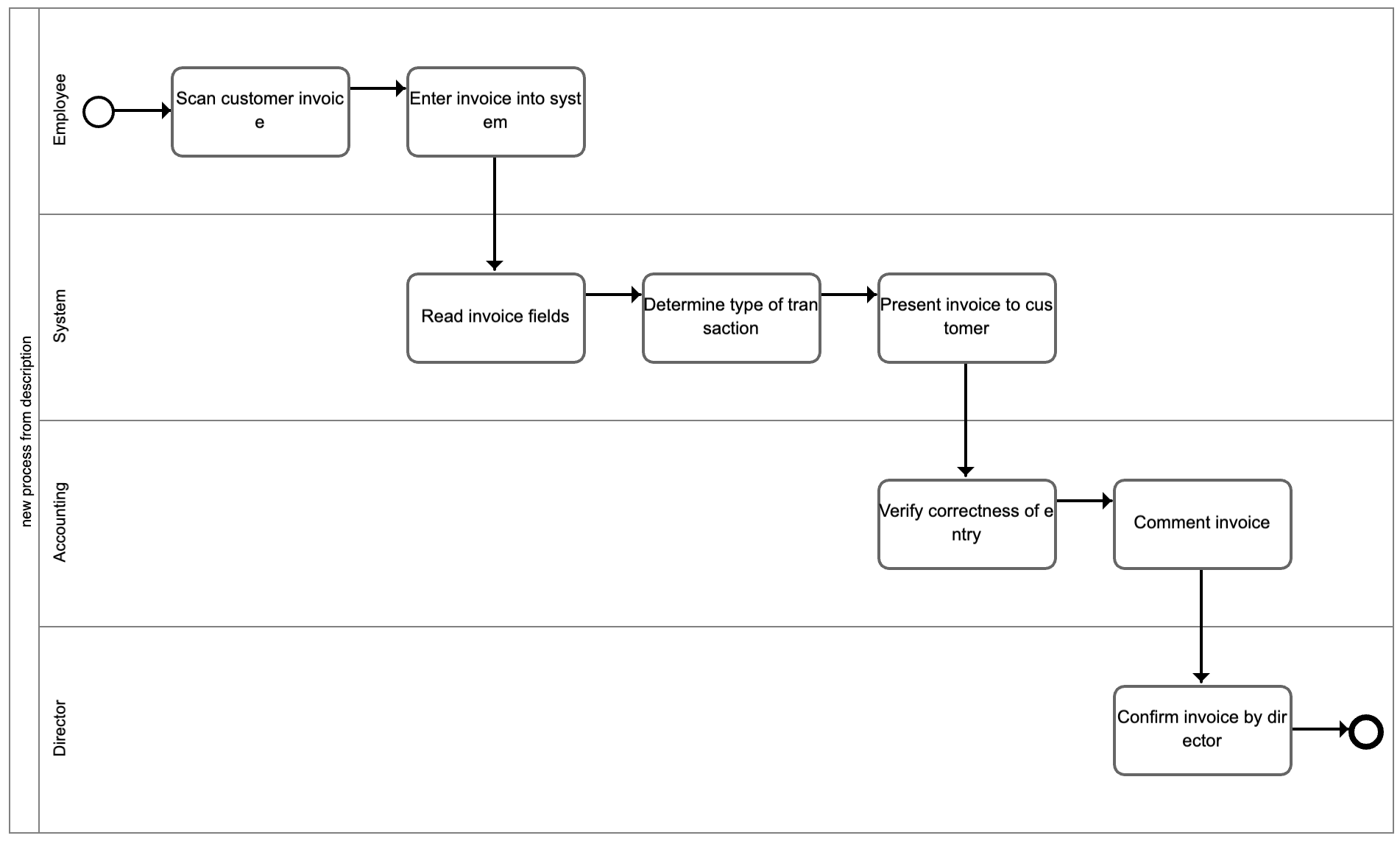

W październiku rusza kolejna edycja studiów Zarządzanie projektem IT oraz Zarządzanie wymaganiami i analiza biznesowa na Akademii Koźmińskiego.

W październiku rusza kolejna edycja studiów Zarządzanie projektem IT oraz Zarządzanie wymaganiami i analiza biznesowa na Akademii Koźmińskiego.

Jak co roku wprowadziliśmy kilka modyfikacji. W przypadku ZPIT to zredukowanie czasu na zarządzanie ryzykiem ilościowe charakterystyczne dla projektów kaskadowych, a rozszerzenie o jeden dzień rozważań na temat zarządzania wymaganiami (BPMN i UML) oraz elementy zarządzania eksploracją.

W przypadku ZWAB dodaliśmy moduł na temat zastosowania sztucznej inteligencji, a dokładnie modeli językowych, w analizie wymagań na bazie naszych doświadczeń zdobytych przy tworzeniu narzędzi takich, jak Dot Chart, GoodBA i Sopulo.

I teraz ważna informacja. Już zrekrutowaliśmy po jednej grupie na ZPIT i ZWAB, ale ponieważ zebrała nam się kolejka chętnych na oba kierunki, to wspólnie z Akademia Koźmińskiego uruchomiliśmy rekrutację na dodatkowe, równoległe grupy, które uruchomią się miesiąc później. Serdecznie zapraszamy wszystkich chętnych.

Linki do studiów:

Zdjęcie: Akademia Koźmińskiego

utworzone przez Marcin Żmigrodzki

Postanowiłem zrobić kolejny krok, analizując możliwości sztucznej inteligencji w analizie wymagań. Napisałem system, który na podstawie wczytanej dokumentacji ma zadanie napisać instrukcję stanowiskową.

Postanowiłem zrobić kolejny krok, analizując możliwości sztucznej inteligencji w analizie wymagań. Napisałem system, który na podstawie wczytanej dokumentacji ma zadanie napisać instrukcję stanowiskową.

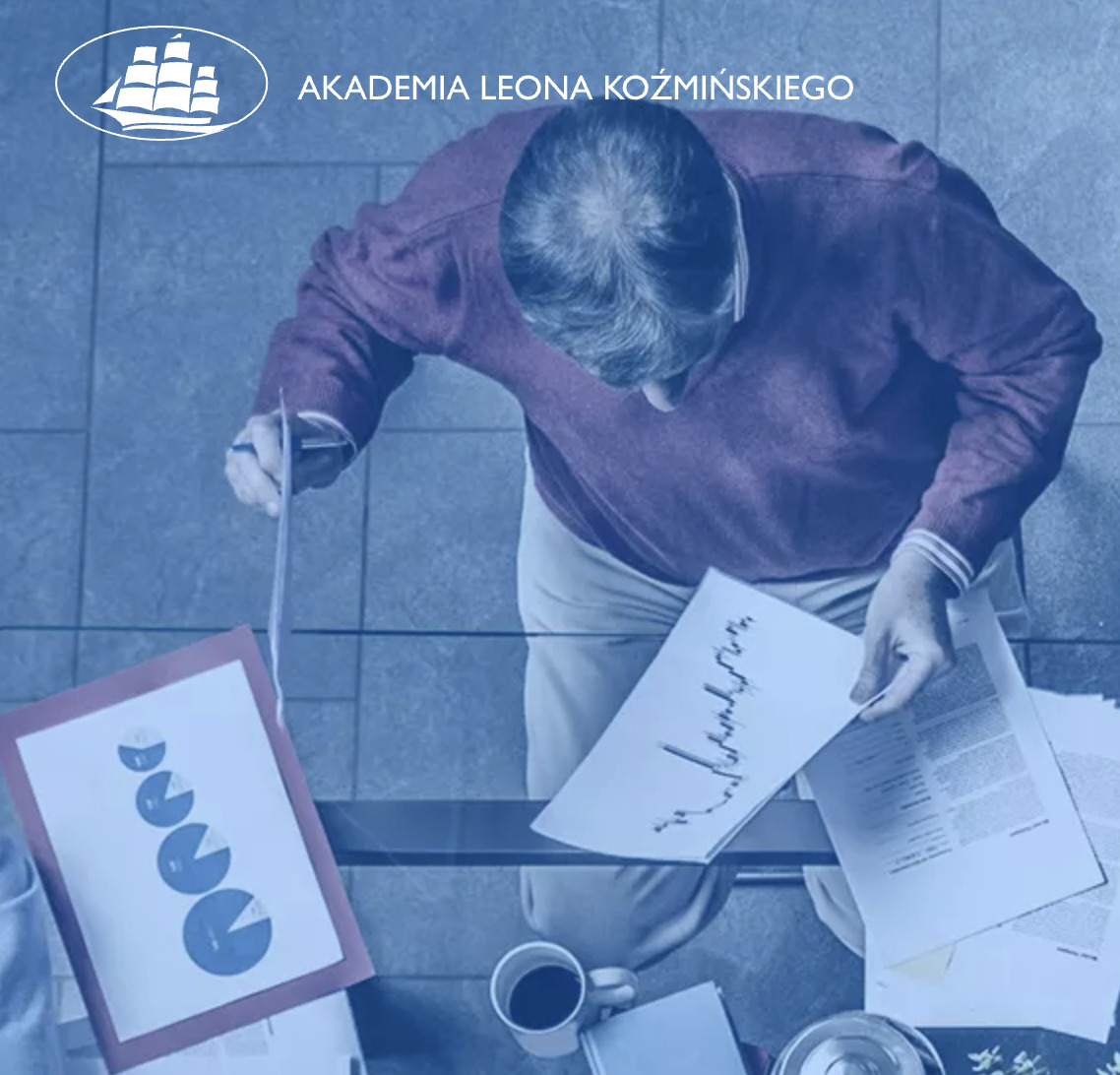

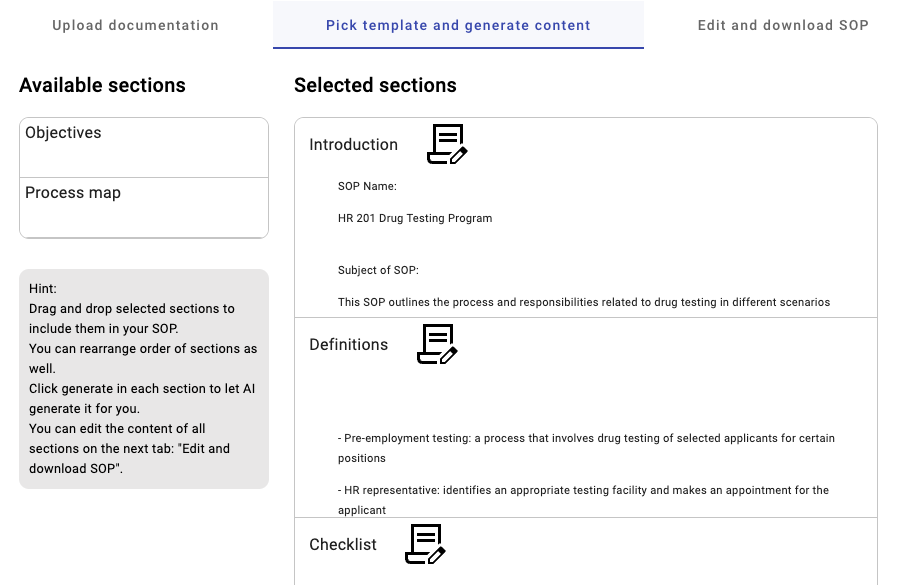

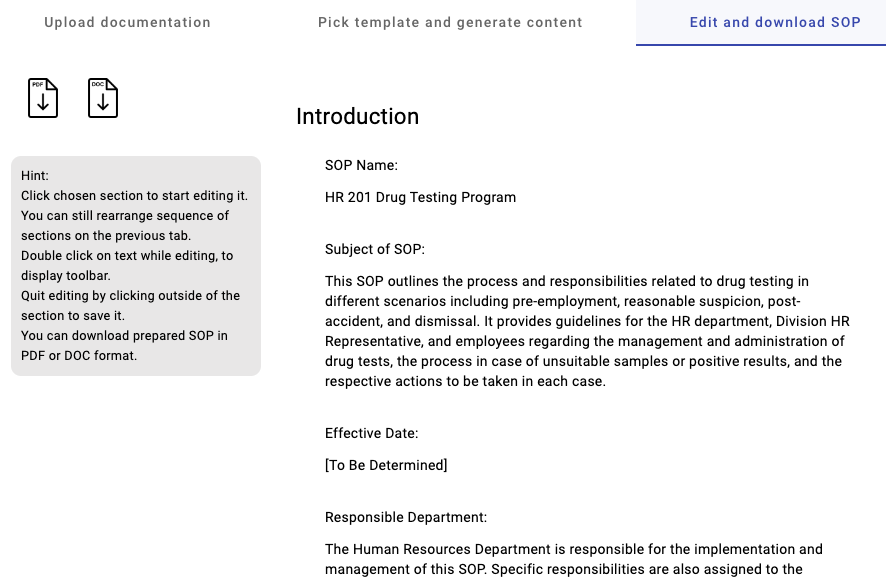

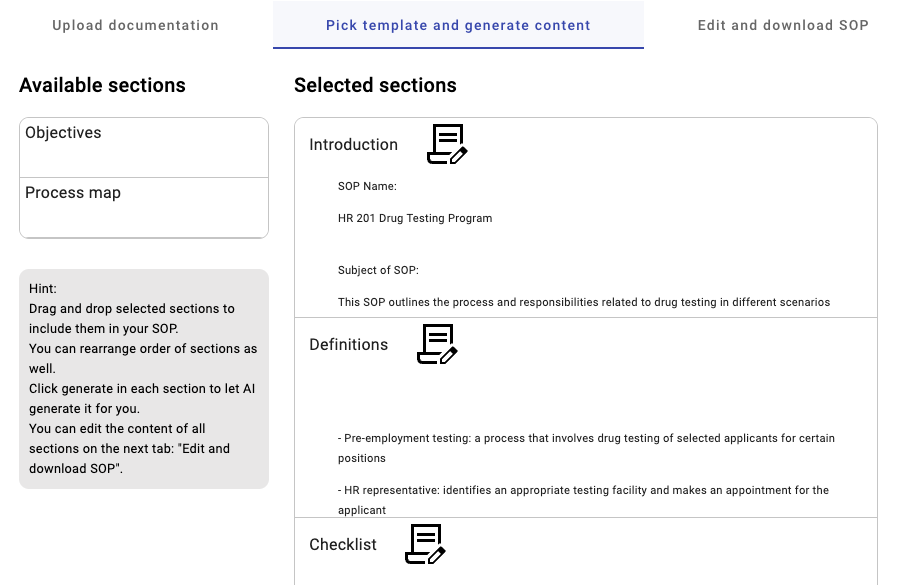

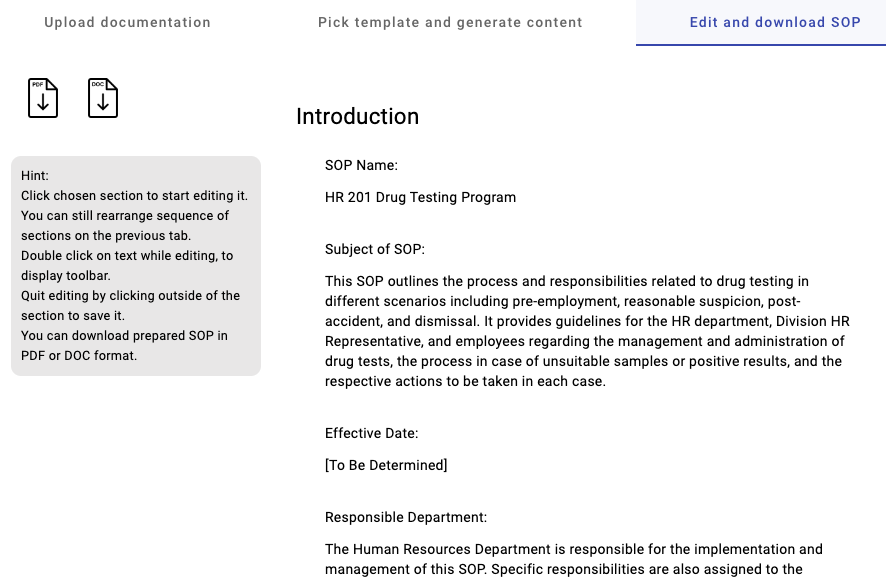

SOPULO działa w trzech krokach:

- Prosi o wczytanie dokumentów opisujących dany proces. Następnie je automatycznie analizuje od strony zawartości.

- Prosi o wybranie sekcji dokumentu SOP, które mają pojawić się w finalnym dokumencie. Użytkownik może dowolnie poprzestawiać ich kolejność przez przeciąganie i upuszczanie.

- Każda sekcja może zostać automatycznie wygenerowana przez algorytm sztucznej inteligencji. Jeżeli użytkownikowi spodoba się rezultat, może przejść dalej. Jeżeli nie, to może ponowić generowanie, albo cofnąć się do kroku wcześniejszego i wczytać więcej dokumentacji.

- Na kolejnej zakładce użytkownik może edytować wygenerowane treści według własnego uznania.

- Wreszcie całość można pobrać w formacie PDF lub DOC do dalszej obróbki.

SOP (standard operating procedure) to dokument opisujący, w jaki sposób powinien zachować się pracownik w ramach pracy w danym procesie. Z jednej strony ujmuje proces w zawężonej perspektywie wybranej roli/aktora, a z drugiej strony dodatkowo zawiera informacje o oczekiwaniach jakościowych pracy, etykiecie, sposobie rozmowy z klientem, warunkach brzegowych, sposobach poprawnego wykonania zadania itd.

Idea tworzenia SOP powstała w wojsku amerykańskim, a stamtąd przeniosła się do procedur medycznych. Dzisiaj rozlewa się na świat biznesu. Odbiorcą SOP jest konkretny operator w procesie i celem jest zwiększenie jakości i powtarzalności wykonywanej pracy.

To wciąż jest prototyp i ciągle jest poprawiany. Natomiast to, co mnie przede wszystkim interesuje to, czy nawyki i oczekiwania pracowników zmieniają się w kierunku wykorzystywania takich narzędzi jak Sopulo zamiast ręcznego pisania dokumentacji.

To wciąż jest prototyp i ciągle jest poprawiany. Natomiast to, co mnie przede wszystkim interesuje to, czy nawyki i oczekiwania pracowników zmieniają się w kierunku wykorzystywania takich narzędzi jak Sopulo zamiast ręcznego pisania dokumentacji.

A tutaj link do systemu: https://sopulo.com/

Zapraszam do używania i jestem bardzo ciekaw waszych uwag.

utworzone przez Marcin Żmigrodzki

Od 20 do 22 września będzie miała miejsce we Wrocławiu konferencja o nazwie Management 360. Jest to już kolejna edycja tego wydarzenia i w poprzednim roku wzięło w nim udział ponad 200 uczestników.

Byłem rok temu i muszę przyznać, że naprawdę profesjonalnie zorganizowane wydarzenie i okazja spotkania wielu fajnych ludzi z branży. Cały dwa dni i noc spędziłem na intensywnych dyskusja z ludźmi z naprawdę różnych światów, w tym z wojska. 🙂

Polecam!

I tu prezent dla Was. Każdy, kto przy rejestracji poda kod OCTIGO10 otrzyma 10% upustu na bilety.

A tu link do strony konferencji: https://management360.pl/

utworzone przez Marcin Żmigrodzki

Wprowadzenie

Pojawienie się algorytmów generatywnych języka naturalnego uruchomiło lawinę rozwiązań. Dzisiaj mamy na rynku dostępnych grubo ponad 1000 startupów, które wykorzystują GPT. Za chwilę, gdy Google udostępni swojego Palm, pojawią się dziesiątki rozwiązań opartych na tym algorytmie.

Generalnie traktuję te algorytmy jako „czarne skrzynki” przetwarzające jedne teksty w drugie i to całkiem sprytnie, czyli takie, które człowiek może twórczo interpretować. Dotyczy to wszelkich prac biurowych w sektorze publicznym (decyzje, pisma urzędnicze), jak i prywatnym (komunikacja z klientem, księgowość, ofertowanie, treści marketingowe, dokumenty prawne).

Gdzie sztuczna inteligencja już działa

W aspekcie zarządzania projektami miejsce zastosowania takich algorytmów pojawia się wszędzie tam, gdzie mamy do czynienia z tekstem na wejściu i tekstem na wyjściu. Idąc od początku cyklu życia projektu, takie miejsca można zauważyć na przykład na etapach:

W aspekcie zarządzania projektami miejsce zastosowania takich algorytmów pojawia się wszędzie tam, gdzie mamy do czynienia z tekstem na wejściu i tekstem na wyjściu. Idąc od początku cyklu życia projektu, takie miejsca można zauważyć na przykład na etapach:

- Inicjacji projektu – odpowiednio podrasowany GPT potrafi już tworzyć typowe dokumenty. Brzmią one dosyć generatywnie, jak gdyby pisał je student zarządzania projektami, ale to moim zdaniem kwestia zbioru uczącego. Dobry fine-tuning modelu i karty projekty będą wyglądały, jak złoto. Obok macie przykład project chartera wygenerowanego dla zadanego przykładu. Z resztą możecie sami sprawdzić na GoodBA, jak to działa. Dodam tylko, że GoodBA korzysta z GPT 3, a załączony przykład jest z GPT 4 i widać tu postęp technologiczny.

- Analizy wymagań – aby sprawdzić, możliwości automatyzowania analizy wymagań, stworzyłem system GoodBA. W mojej opinii, dla generatywnych aplikacji działa to całkiem nieźle. Więcej o takim podejściu do analizy wymagań przeczytasz tutaj.

- Planowania zakresu – mając dobrze opisane wymagania, GPT naprawdę nieźle daje sobie radę ze stworzeniem planu zakresu w formule WBS, czy tez Backlog. Naprawdę niewiele trzeba po nim poprawiać, bo w tym wypadku robi to, co umie najlepiej restrukturyzuje podany mu tekst.

- Planowania ryzyk – wyobrażam sobie i chętnie sprawdziłbym to na przykładzie jakiejś firmy, że gdyby wytrenować model GPT na zbiorze danych o ryzykach z przeszłych projektów, to mógłby generować całkiem porządną wstępną analizę ryzyk dla kolejnego. Zakładam, że musiałaby to być baza zawierająca nie tyle przewidywane ryzyka, co rzeczywiście występujące w historycznych projektach.

- Prz

ygotowania kontraktów – w tym obszarze pojawiło się wiele startupów, które pozwalają na generowanie pism prawnych, w tym umów. Niech najlepiej o możliwościach automatyzacji obszaru prawnego świadczy olbrzymi spadek notowań giganta prawnego z USA – Legalzoom, który można było obserwować w momencie wydania GPT 3. Obok macie wykres kursów Legalzoom – spadek o 70%!

ygotowania kontraktów – w tym obszarze pojawiło się wiele startupów, które pozwalają na generowanie pism prawnych, w tym umów. Niech najlepiej o możliwościach automatyzacji obszaru prawnego świadczy olbrzymi spadek notowań giganta prawnego z USA – Legalzoom, który można było obserwować w momencie wydania GPT 3. Obok macie wykres kursów Legalzoom – spadek o 70%!

- Komunikacji z interesariuszami – Notion wypuściło moduł AI, a Nuclino – Sidekick. Oba to integracje z GPT mające na celu przyśpieszyć komunikację z użytkownikami. Wystarczy napisać swój komunikat, a potem poprosić, aby automat dodał do tego trochę energii, zmienił klimat na weselszy, wydłużył o dwa akapity oraz przetłumaczył na mongolski. I wszystko to automatycznie.

A gdzie jeszcze nie działa AI

GPT słabo sobie daje radę z wnioskowaniem symbolicznym. Widziałem próby pytania go o działania matematyczne, ale poziom błędowości tutaj jest wciąż wysoki. Jest to algorytm do przewidywania, jaki tekst powinien być napisany po zadanym prompt’cie. W efekcie dopisuje absurdalne wyniki. W przypadku matematyki obejściem tego problemu jest skorzystanie z pluginu Wolfram. Jednak, jeżeli wyobraziłbym sobie wygenerowanie tabeli z kosztami projektu na podstawie opisu wymagań i obciążenia zasobów, to bym poległ.

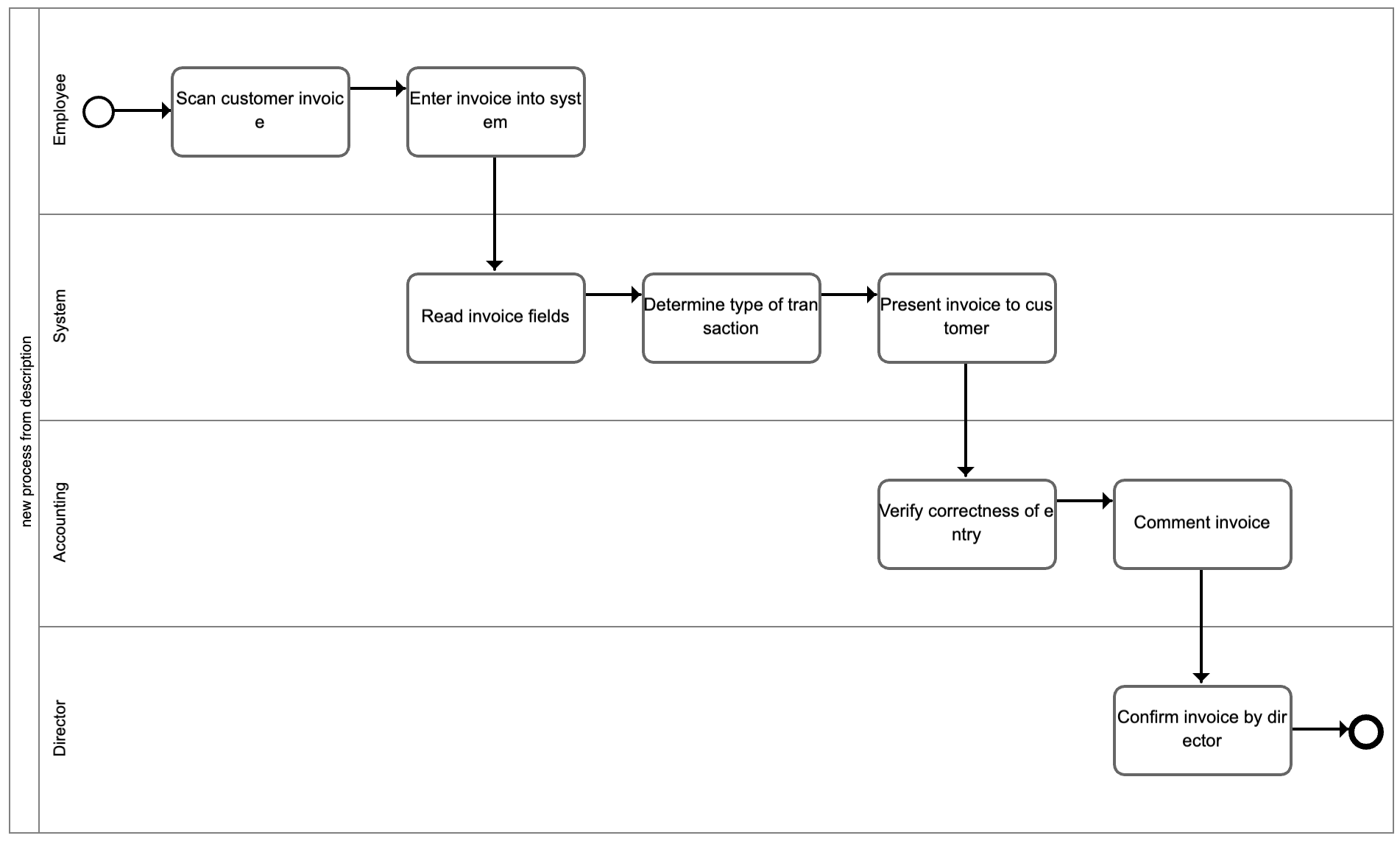

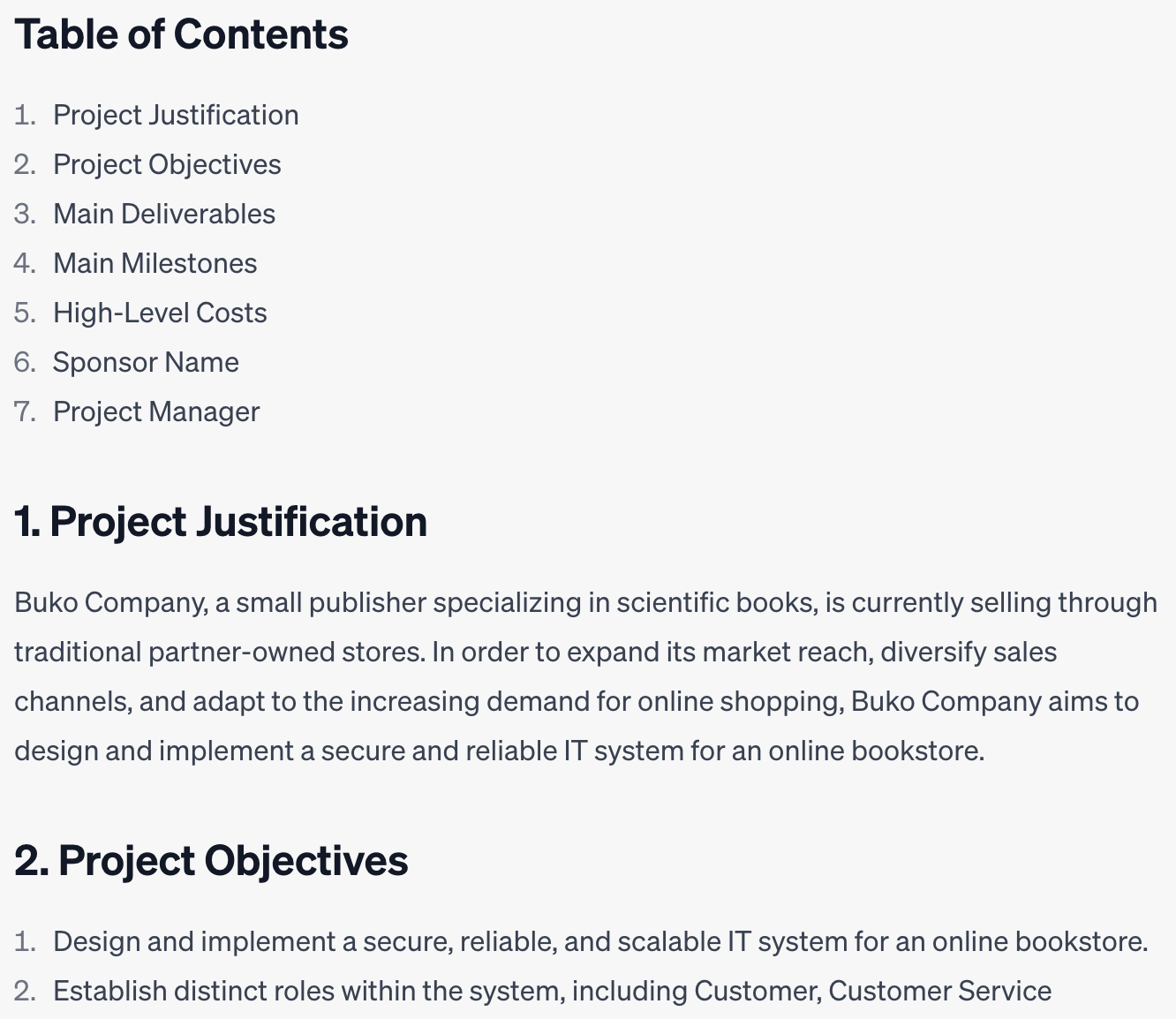

Pewne nadzieje daje technika pisania promptów zwana chain of thought, czyli tworzenie serii zapytań, w toku których powstaje ustrukturalizowany opis, na podstawie którego z kolei można wygenerować bardziej zaawansowane modele. Sam wykorzystuję to do generowania map procesów w systemie Dot Chart. Obok macie przykład mapy procesu, która została wygenerowana automatycznie na podstawie opisu językiem naturalnym.

Pewne nadzieje daje technika pisania promptów zwana chain of thought, czyli tworzenie serii zapytań, w toku których powstaje ustrukturalizowany opis, na podstawie którego z kolei można wygenerować bardziej zaawansowane modele. Sam wykorzystuję to do generowania map procesów w systemie Dot Chart. Obok macie przykład mapy procesu, która została wygenerowana automatycznie na podstawie opisu językiem naturalnym.

Oczami wyobraźni widzę algorytm, który z jednej strony przetwarza teksty pisane językiem naturalnym, ale równolegle z drugiej strony identyfikuje wartości zawarte w tekście i wnioskuje na ich podstawie w sposób bardziej symboliczny tak, jak robią to algorytmy uczenia maszynowego. Taka hybryda GPT i ML.

Kolejny problem związany z brakiem wnioskowania symbolicznego jest słaba jakość rewizji utworzonej dokumentacji. Właściwie zawsze człowiek musi przejrzeć to, co utworzył GPT i przynajmniej lekko zmodyfikować. Algorytm nie potrafi skutecznie wykryć wszystkich luk i niespójności w wygenerowanym tekście na podstawie zadanych kryteriów. Testowałem go na przykładzie studów przypadków biznesowych i osiąga tutaj połowiczny sukces.

Wreszcie GPT słabo sobie radzi z treściami specyficznymi dla konkretnej firmy lub organizacji publicznej. To, co generuje jest raczej dość ogólne. Gdyby chcieć stworzyć opis programu na przykład do obliczania ryzykowności klientów banku detalicznego, to zapewne polegnie. Ale mamy tutaj rozwiazanie pod ręką, a jest nim „fine-tuning”. Jestem po lekturze dokumentacji, jak podkręcać GPT, ale niestety nie mam dostępu do przykładowych treści z jakiejś organizacji, aby przeprowadzić samodzielne testy. Mam nadzieję, że przez wakacje uda mi się wygenerować jakiś prototyp również w tym aspekcie.

Podsumowanie

Całość mógłbym podsumować stwierdzeniem, że zniknie syndrom czystej kartki. Chodzi mi o sytuację, gdy kierownik projektu będzie siadał do planowania projektu z czystą kartką i ją mozolnie wypełniał. Wkrótce będzie siadał z wstępnie wypełnionym dokumentem, czyli zawierającym 80%-90% treści, który będzie musiał sprawdzić, uzupełnić o braki i nadać mu bardziej ludzki ton, np. wprowadzić kilka drobnych błędów. 😉

Ale rewolucja AI w moim przekonaniu oznacza koniec pracy nad czystą kartką. Coś na starcie zawsze będzie na niej wpisane przez algorytmy sztucznej inteligencji.

Przy okazji niedawnego szkolenia w ręce wpadła mi metodyka PRISM przygotowana przez stowarzyszenie Green Project Management. Postanowiłem się podzielić moimi spostrzeżeniami na temat tej metodyki i w ogóle podejścia Green Project Management.

Przy okazji niedawnego szkolenia w ręce wpadła mi metodyka PRISM przygotowana przez stowarzyszenie Green Project Management. Postanowiłem się podzielić moimi spostrzeżeniami na temat tej metodyki i w ogóle podejścia Green Project Management.

W październiku rusza kolejna edycja studiów Zarządzanie projektem IT oraz Zarządzanie wymaganiami i analiza biznesowa na Akademii Koźmińskiego.

W październiku rusza kolejna edycja studiów Zarządzanie projektem IT oraz Zarządzanie wymaganiami i analiza biznesowa na Akademii Koźmińskiego.

To wciąż jest prototyp i ciągle jest poprawiany. Natomiast to, co mnie przede wszystkim interesuje to, czy nawyki i oczekiwania pracowników zmieniają się w kierunku wykorzystywania takich narzędzi jak Sopulo zamiast ręcznego pisania dokumentacji.

To wciąż jest prototyp i ciągle jest poprawiany. Natomiast to, co mnie przede wszystkim interesuje to, czy nawyki i oczekiwania pracowników zmieniają się w kierunku wykorzystywania takich narzędzi jak Sopulo zamiast ręcznego pisania dokumentacji.

W aspekcie zarządzania projektami miejsce zastosowania takich algorytmów pojawia się wszędzie tam, gdzie mamy do czynienia z tekstem na wejściu i tekstem na wyjściu. Idąc od początku cyklu życia projektu, takie miejsca można zauważyć na przykład na etapach:

W aspekcie zarządzania projektami miejsce zastosowania takich algorytmów pojawia się wszędzie tam, gdzie mamy do czynienia z tekstem na wejściu i tekstem na wyjściu. Idąc od początku cyklu życia projektu, takie miejsca można zauważyć na przykład na etapach: ygotowania kontraktów – w tym obszarze pojawiło się wiele startupów, które pozwalają na generowanie pism prawnych, w tym umów. Niech najlepiej o możliwościach automatyzacji obszaru prawnego świadczy olbrzymi spadek notowań giganta prawnego z USA – Legalzoom, który można było obserwować w momencie wydania GPT 3. Obok macie wykres kursów Legalzoom – spadek o 70%!

ygotowania kontraktów – w tym obszarze pojawiło się wiele startupów, które pozwalają na generowanie pism prawnych, w tym umów. Niech najlepiej o możliwościach automatyzacji obszaru prawnego świadczy olbrzymi spadek notowań giganta prawnego z USA – Legalzoom, który można było obserwować w momencie wydania GPT 3. Obok macie wykres kursów Legalzoom – spadek o 70%!